- HOME

- AUKOE の コエ

- 生成AI活用でも大切なデータ処理のセキュリティとコストの視点~「大は小を兼ねる」LLMと「小さくても尖った」SLM~

生成AI活用でも大切なデータ処理のセキュリティとコストの視点~「大は小を兼ねる」LLMと「小さくても尖った」SLM~

- category : AUKOE の コエ

- writer : 安井秀行(アスコエパートナーズ)

index

本記事は、2025年(令和7年)12月22日(月)発行の時事通信社『地方行政』の【連載】ポスト標準化の自治体DX③ データ駆動の自治体へ に掲載された内容を転載したものです。

1.はじめに~LLMの視点から見た行政機関で生成AIを使う際のポイント

前回に引き続き、本稿でも自治体における生成AI(人工知能)利活用についてお話ししたいと思います。特に今回は、生成AIが扱うデータ処理のセキュリティとコストの視点についてのお話です。

生成AIブームを背景に、大規模言語モデル(Large Language Model、以下LLM)という言葉を耳にした方も多いと思います。LLMとは、膨大な文章データを学習し、自然な文章を作ったり、質問に答えたりできる生成AIの中核となる仕組みです。しかし、行政機関、特に自治体においては、LLMが便利なあまり、業務へどんどん導入することの方へ視点がいきがちですが、LLMをそのまま業務に導入することに対して慎重になるべき理由が幾つか存在します。

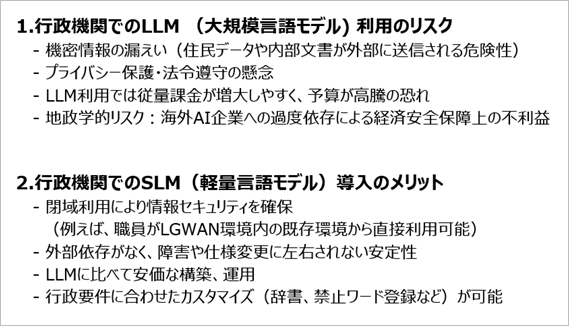

第一に、情報漏洩のリスクです。一般に利用されるLLMはインターネット上で提供されるクラウドサービスである場合が多く、住民情報や内部文書など機密性の高いデータを扱おうとすると、外部のサーバーへ送信されてしまう可能性があります。その結果、意図せず機密情報が外部に漏洩する危険性が指摘されています。これはプライバシー保護の懸念に直結します。自治体は個人情報保護等の法令に厳格に従う必要があり、外部AIサービスの利用はその遵守を脅かすリスクを伴います。

第二に、LLMは非常に便利で高機能ですが、使い方により利用料金が高額になる可能性があります。これは、LLMが本来、世界中のあらゆる質問に対応できるよう設計されており、行政での利用範囲に比べて明らかに”過剰性能”であるケースがあるためです。

LLMは高度な推論能力や言語処理など、多くの行政現場では使い切れないほどの能力を備えています。その高機能を維持するために膨大な計算資源が必要であり、利用料金も必然的に高額になる傾向があり、「とても賢いが、その賢さの大部分は自治体業務では過剰」という状況が想定されます。

また、LLMの料金は従量課金が一般的であり、結果として、利用料金が高額になる可能性があり、従量課金でも長文のやりとりが多くなりがちな行政現場では料金が雪だるま式に増える危険があります。

第三に、地政学的リスクの問題も看過できません。現状、強力なLLMの多くは海外企業により提供されており、それらに過度に依存すると、国際情勢の変化や提供企業の方針転換によって利用制限やサービス停止の影響を受ける恐れがあります。

以上のような理由から、自治体でLLMを利便性の視点だけで安易に利用することには慎重な姿勢も必要かもしれません。

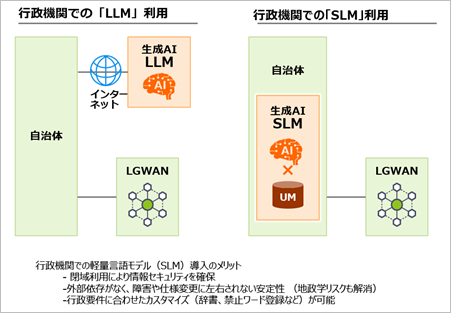

こうしたリスクへの対策として、自治体では業務ネットワークを外部と切り離した形でAIを活用する可能性も検討されています。具体的には、自治体専用の閉域ネットワークであるLGWAN内でAIを運用することです。LGWAN内部で完結するAIであれば、機密情報がインターネットに流出する心配がなく、上記のプライバシー・セキュリティ上の懸念を大きく軽減できます。

図1 自治体向けの生成AIは、LLMからSLMへ

しかし、巨大なLLMを自治体自前で運用するには相応の投資が必要であり、現実的には大きな困難が伴います。そのため一つの選択肢として、昨今注目されているのが、より小規模で軽量な言語モデル、すなわちSLMです。そこでこのSLMを例にとって、自治体内での生成AI利用に関するセキュリティやコストについてのアプローチ例を説明してみたいと思います。

2.小規模言語モデル(SLM)導入の可能性

小規模言語モデル(Small Language Model、以下SLM)とは、LLMに比べてモデル規模が小さく、必要な計算資源も抑えられた言語モデルを指します。SLMは、例えば法律・金融・医療など特定分野に特化した小規模な言語モデルであり、その分野の専門知識を深く持つように専門テキストで学習されています。

パラメータ数がLLMより少なく、計算資源も抑えられるため、短時間かつ低コストで開発・運用でき、ローカルPCでも動作可能なモデルもあります。このような特徴から、コスト削減やデータのオンプレミス管理を重視する企業や自治体にとって、SLMの導入は魅力的な選択肢の一つとなる可能性があります。

特に、SLMを自治体が導入することには幾つかのメリットがあります(図1、2)。 第一に、SLMは小型のためオンプレミスや閉域ネットワークでも動かしやすいという特徴があります。LGWAN環境での閉域運用が可能となり、情報セキュリティを確保できるのです。外部に通信せず庁内ネットワーク内でAIが完結するため、住民データや業務情報を安全に扱うことができます。また、職員が既存の業務システムや端末から直接AIを利用できるため、日常業務にスムーズに組み込むことができ、業務効率の向上につながります。例えば、職員が文書作成やデータ整理でAIアシスタントを使う際、わざわざインターネット接続された別サービスにアクセスする必要がなければ、データアクセスの制限から解放され、より活用シーンを広げることができるでしょう。

第二に、SLMは、LLMと比べて”必要な性能に絞った、軽くて安価な生成AI”になる可能性があります。自治体での利用を考えると、SLMのこのコストの側面は非常に魅力的です。

他方、LLMは大量のデータを学習し、世界中のさまざまな質問に答えられるように設計されているため、性能が非常に高い半面、維持や利用のために膨大な計算資源を必要とします。

一方、SLMは行政で必要な範囲に特化して作ることができるため、無駄な機能が少なく、その分軽量で低コストに動かせるという大きなメリットがあります。例えば、「税」「福祉」「子育て」など自治体固有の情報を中心に学習させれば、必要な場面で十分な精度を発揮できます。自治体で利用する生成AIには、「ホットケーキの作り方」や「大谷翔平選手のホームラン」に関する自治体業務に関係の無い知識は不要です。

第三に、行政の要件に合わせたカスタマイズが容易という利点も見逃せません。モデルに行政特有の用語を覚えさせるための辞書を組み込んだり、不適切な単語の出力を防ぐための禁止ワード設定を行ったりと、自治体のニーズに沿った調整が可能です。LLMのような汎用モデルでは難しい細かなチューニングを、自前環境のSLMであれば実施しやすく、またSLMなら小規模な学習で済むため、年度改正や制度変更にも現実的なコストで対応できます。

第四に、SLMは外部サービスへの依存がないため、外部要因による障害や仕様変更に左右されにくく、安定性が高いという利点もあります。海外ベンダーへの依存を減らせる点で、先に述べた地政学的リスクの軽減策にもなります。

図2 行政機関でのLLMとSLM利用

まとめると、SLMは「自治体で必要な知識だけを持ち、無駄な性能を削ったコンパクトなAI」であり、低コスト・高安全性・必要十分な精度という三拍子が揃う可能性があります。

LLMが”高級車”だとすれば、SLMは”燃費がよく、目的に合った実用車”。こうした視点に立てば、自治体にとってはSLMが一つの選択肢になるのではと筆者は考えています。

もっとも、現状においてSLMは巨大なLLMと比べて、知識量や推論力の点で見劣りする場合が多いのも事実です。公開されている大規模モデルに比べてパラメータ数が少なく、学習データの範囲も限られるため、専門的な質問に対する網羅的な回答や、高度に複雑な推論を要する課題については苦手とする傾向があります。それでも、国内でもすでに大手企業やスタートアップ企業が自治体向けの生成AIサービスに参入し始めており、それらの多くは比較的小規模な独自モデルや日本語特化モデルを用いて、また行政の法令データ等と組み合わせることで、自治体業務での活用を模索しています。こうした動きは、最新のAI技術と行政実務の知見を結び付ける試みであり、LLM、SLMを問わず必要な知識を付加することで、自治体業務に耐え得る性能を発揮させることが鍵となります。

3.SLM精度向上へのユニバーサルメニューの活用

前回(12月15日号)でご紹介したユニバーサルメニュー(以下、UM)は、行政関連の知識を付加するための現実的な手法の一つとして、SLMの精度向上に大いに貢献することができます。前述の通り、SLM単体では知識の偏りや抜け漏れが生じがちですが、UMは行政の標準的な制度知識を数百件にわたり網羅しているため、SLMに不足する専門知識を補う土台となります。

具体的な活用方法の一つとしては、UMデータを用いたSLMの追加学習(ファインチューニング)や、RAGと呼ばれる生成AIが回答を生成する際に外部データベースから関連情報を検索する手法が挙げられます。UMの中のUMテンプレートには各制度の正式名称や略称、制度の目的・対象・内容といった定型項目の説明が含まれており、これらを学習させることで、モデルに行政サービスの正規の知識を与えることができます。これにより、住民からの質問に対して抜け漏れのない的確な回答を生成しやすくなります。

特にUMテンプレートは、住民に伝わりやすい文体でありながら行政実務に耐える正確さを備えており、現場で培われた専門家の知見が凝縮されています。言い換えれば、UMを活用することで、SLMに「行政サービス説明のプロ」のノウハウを移植することが可能になるのです。

例えば、住民から「○○手当の対象者は誰ですか?」と質問があった場合、モデルはUMテンプレート内の当該手当の「対象者」項目を参照し、最新かつ正確な条件を踏まえた回答を生成することが可能です。このRAG運用により、モデルが内包する知識だけに頼らずとも、最新で網羅的な情報提供を実現できます。SLMの軽量さを保ちながら、LLMに匹敵する知識の網羅性や正確性を引き出す上で、UMとRAGの組み合わせは有力な解決策となります。

4.まとめ~生成AI活用でも大切な性能とコスト・リスクのバランス

職員数の減少と業務効率化のニーズを背景に、自治体のAI活用への期待はますます高まっています。一方、生成AIの変化は大変激しく、最近は安価なLLMや、自治体がLGWANの中からLLMにコンタクトできるソリューションも出てきています。それでも、LLMの場合は自治体内部データが学習に使われるリスクや、地政学的な理由も含めてコストが上がる懸念も拭えません。正直なところ、本当に最適な解が何かは、現時点では私も言い切れません。

しかしながら、今後LLMを利用していく際には、SLMの存在も意識しながら自治体での生成AI導入を賢く進めていく必要があるのではないかと考えています。

真に現場で役立つAIを実現するためには、今後は、技術力だけでなく、法制度や行政手続きに関する深い知識を組み合わせて、自治体ごとに適合したAIソリューションを育てていく姿勢が求められるでしょう。将来的には、国産SLMの性能向上に伴い、各自治体が低コストで高性能なAI基盤を共有できる時代が来るかもしれません。

最終的には、LLMの高度な利便性に安易に飛びつくのではなく、SLMとUMを組み合わせた堅実かつ現実的な道筋で行政DXを着実に前進させることも大切な選択肢であると筆者は考えています。このアプローチは、住民サービスの向上と業務効率化の双方を実現し得る、有望な道筋の一つとなる可能性があります。

この記事を書いたのは:安井秀行(アスコエパートナーズ)

株式会社アスコエパートナーズ 代表取締役社長 NPO団体 アスコエ代表 一般社団法人ユニバーサルメニュー普及協会 理事 慶応義塾大学 政策・メディア研究科 非常勤講師 内閣官房「新戦略推進専門調査会 デジタル・ガバメント分科会」委員 内閣官房「地方官民データ活用推進計画に関する委員会」委員 マッキンゼー・アンド・カンパニー・ジャパン、株式会社DBMG取締役を経て、現職。企業だけでなく、行政等公的機関も含めたウェブ、マーケティング戦略関連の幅広いコンサルティングを行っている。